備註:此為 2025 財年 Q1 財報。(主編定義的 2024Q1 財報)

這季財報的三個收穫都驗證了NVIDIA的絕對領先地位:

- 推論和訓練業務同步大幅成長,且客戶越來越多元分散。

- 和消費性產品不同,當「買的是算力時,時間就是金錢」。(客戶有立即取得當下最高CP值算力的需求,所以市場擔心的換機期間營收凹洞,公司不擔心)

- 再次強化軟體的影響力,軟體優化可以帶來整個NVIDIA生態系更深的護城河。

覺得NVIDIA和他之前說的一樣,真的是搭上光子列車,領先優勢越來越強大,讓其他人都看不到車尾燈。(而市場還沒有完全定價這點)我認為只要大模型追逐沒有停止,NVIDIA的優勢就將維持,可望出現PE-rerate。

財報內容整理

財務表現

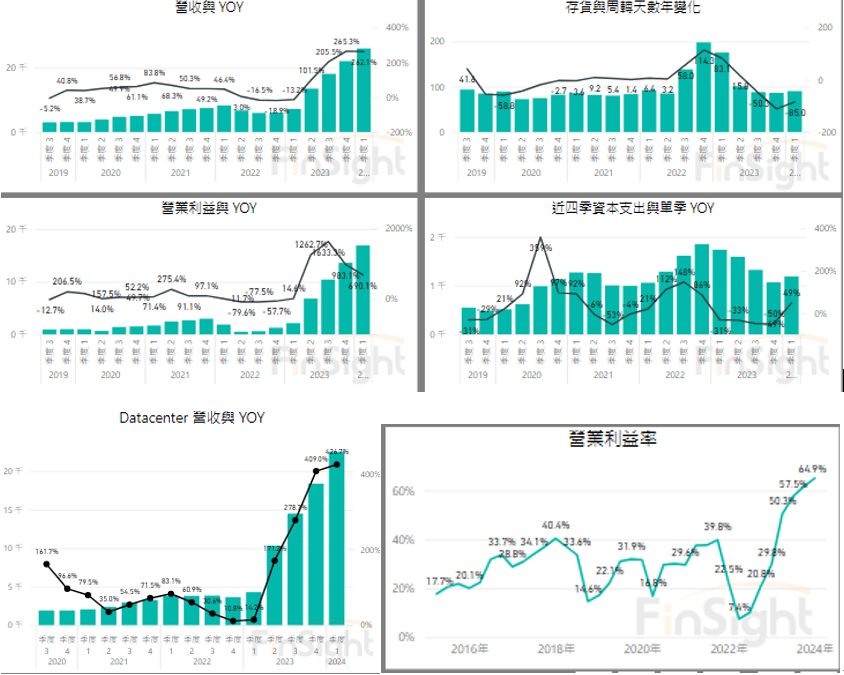

- 營收達到260億美元,同比增長262%,超過預期的240億美元

- 資料中心收入達到226億美元,同比增長427%,主要由於NVIDIA Hopper GPU平台的需求強勁。

(運算收入增長了超過 5 倍,網路收入同比增長超過3倍)

未來展望

- Q2營收預計為280億美元,GAAP毛利率預計為74.8%

(上季給的全年GM Guidance 是 70% 區間的中間值,已隱含B系列晶片價格漲幅較小會開始壓抑毛利率,這季給的數據大致維持目標值)

上一季亮點:推理業務佔比40%

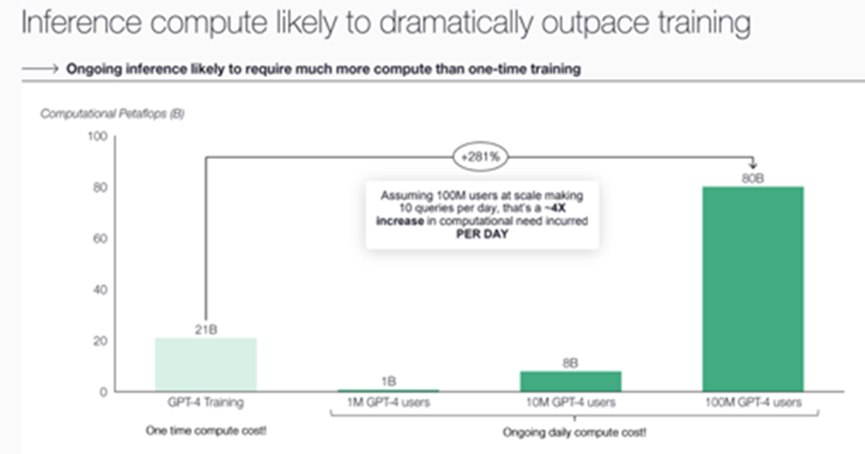

持續的推理計算需求可能遠超一次性的訓練計算需求

- 假設有1億用戶每天進行10次查詢,這會導致計算需求增加4倍

- X軸:一次性計算成本(Training) vs 持續每日計算成本(Inference)

- Y軸:計算需求以PetaFLOPS(每秒一千萬億次浮點運算)為單位

- GPT-4 Training:21B

1M GPT-4 users:1B(每日計算需求)

10M GPT-4 users:8B(每日計算需求)

100M GPT-4 users:80B(每日計算需求)

本季要強調:推理訓練同步大幅成長,且客戶來源越來越廣泛

- 客戶持續分化,強調企業與主權需求持續成長,今年將貢獻數十億美元

- 過去四季推理占資料中心收入的40%左右。訓練和推理都在顯著增長

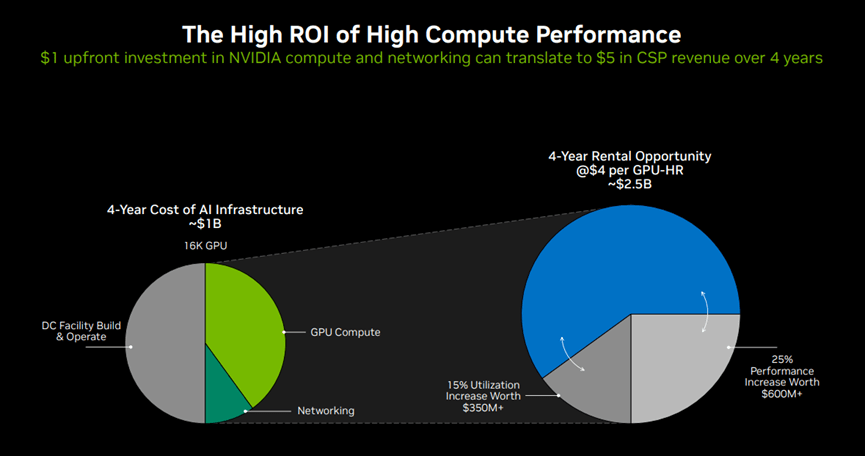

- 雲服務供應商每在 NVIDIA AI 基礎設施上投入 1 美元,可以在 4 年內通過 GPU 即時託管服務獲得 5 美元的回報

| 法說時間 | 公司對資料中心客戶看法 |

| 2022Q4 (2023/2/23) | 過去4個季度,雲服務提供商(CSP)客戶佔NVIDIA數據中心總收入約40%。 |

| 2023Q1 (2023/5/25) | 1. Colette Kress提到他們在雲服務提供者(CSP)、消費互聯網公司和企業這三大客戶類別中都看到了強勁的需求增長。但沒有提供具體的占比數位。 2. Jensen被問到NVIDIA DGX Cloud與CSP雲的理想占比時,他表示理想情況是NVIDIA DGX Cloud占10%,CSP雲占90%。但這是指NVIDIA自己的DGX Cloud業務相對CSP的理想占比,不是整個資料中心收入的客戶占比。(大約是DGX Cloud佔資料中心5% / CSP佔資料中心45%) (DGX Cloud是將硬體賣給超大規模合作夥伴,再租回來用於自己的業務) |

| 2023Q2 (2023/8/24) | 1. 大型雲端服務供應商(CSP)占 NVIDIA 資料中心收入略高於50% 2. 次大類別是消費者互聯網公司 3. 最後是企業客戶和高性能運算 |

| 2023Q3 (2023/11/22) | 1. 消費性互聯網公司和企業客戶推動了第三季非常強勁的環比增長,佔資料中心收入的大約一半,增速超過整體增長。這些客戶包括Meta等公司,他們正在大規模生產使用深度學習推薦系統,並投資生成式AI來幫助廣告主優化圖像和文本。大多數主要的消費互聯網公司正在爭相加快部署生成式AI。 2. 雲服務提供商大約貢獻了另一半的資料中心收入。需求來自所有的超大規模雲服務商,以及全球範圍內快速增長的GPU專用雲服務商,他們正在快速成長以應對AI帶來的新市場機會。 3. 企業客戶的AI應用浪潮現在正在開始。 |

| 2023Q4 (2024/2/22) | 1. 大型雲端供應商在第四季度佔NVIDIA資料中心收入的50%以上,同時支援內部工作負載和外部公有雲客戶。 2. 消費互聯網公司是NVIDIA的最大客戶類別之一,他們在搜索、電商、社交媒體、新聞和視頻服務、娛樂等領域使用AI來改進深度學習的推薦系統。 3. 企業軟件公司正在應用生成式AI來幫助客戶實現生產力提升,像ServiceNow等。 4. 各行業的企業客戶採用AI的比例顯著提高,如汽車、醫療保健、金融服務等。汽車產業通過雲或內部部署對NVIDIA資料中心的收入貢獻去年超過10億美元(佔NVDA營收 2.1%)。 5. 中國的資料中心收入在第四季度佔個位數百分比,預計第一季度保持類似水準。 6. 美國以外其他地區的主權AI計劃成為額外的需求驅動因素。 7.首次談到推理業務佔比40%。 總的來說,大型雲端供應商、消費互聯網公司是最大的兩類資料中心客戶,而企業客戶的佔比正在快速提升,特別是汽車等垂直行業。中國市場因為出口管制而大幅下滑至個位數佔比。 |

| 2024Q1 (2024/5/23) | 1. 大型雲供應商繼續推動強勁增長占資料中心收入的40%左右,因為他們大規模部署和擴展英偉達AI基礎設施。由於 CUDA 軟體的優化,雲服務供應商每在 NVIDIA AI 基礎設施上投入 1 美元,可以在 4 年內通過 GPU 即時託管服務獲得 5 美元的回報。 2. 企業客戶在本季度推動了資料中心的強勁增長。 3. 汽車行業預計將成為英偉達今年資料中心業務中最大的企業垂直市場,推動了本地和雲消費方面數十億美元的收入機會。英偉達支持特斯拉將其AI訓練集群擴展至35000個H100 GPU。 4. 消費互聯網公司也是一個強勁的增長垂直領域。Meta宣佈其最新的大語言模型Llama 3在由24000個H100 GPU組成的集群上進行了訓練。 5. 主權AI收入從之前的零增長到今年可能接近數十億美元。(主權AI指國家使用自己的基礎設施、資料、人力和商業網絡來生產人工智慧的能力。) 隨世界各國投資主權AI,資料中心收入繼續多樣化。例如,日本計畫投資超過7.4億美元建設國家主權AI基礎設施;法國Scaleway正在建設歐洲最強大的雲原生AI超級電腦;義大利Swisscom集團將建造該國第一台也是最強大的NVIDIA DGX驅動的超級電腦;新加坡國家超級計算中心正在用NVIDIA Hopper GPU進行升級。 6. 本季度,英偉達與100多個客戶合作構建AI工廠,規模從數百到數萬個GPU不等,有些達到10萬個GPU。 7. 談到過去四個季度,推理占比40%,其中訓練和推理都在顯著成長。 生成式AI的訓練和推理需求正在推動各類資料中心客戶的強勁增長,包括雲服務供應商、消費互聯網公司、企業、主權AI、汽車和醫療保健行業。 |

對下半年營收凹洞看法:跟手機不一樣,買的是算力,而算力不能等

Q:每年持續推出新品的速度很快,那舊產品的需求?

A:如果你只完成了5%的構建,而不是已經完成了95%,你會有非常不同的感受。對客戶而言時間真的非常寶貴,他們需要現在就賺錢。他們現在就想省錢。舉例來說,下一個達到下一個重大里程碑的公司將有機會宣佈一項突破性的人工智慧成果,而之後的第二個公司只能宣佈比第一個公司好0.3%的成果。所以問題是,你是想反復成為提供突破性AI的公司,還是僅僅提供好0.3%的公司? 領先地位非常重要。訓練時間非常重要。提前3個月完成一個需要3個月的訓練項目,這提前3個月開始至關重要。這就是為什麼我們現在正瘋狂地建立Hopper系統,因為下一個里程碑就在眼前。

Q:您是否預計在過渡到這些產品時,Hopper和H100會出現任何停頓?

A:我們看到本季度對Hopper的需求不斷增加。我們預計在轉向H200和Blackwell時,需求將遠遠超過供應。每個人都急於讓他們的基礎設施上線。這是因為他們正在節省資金並賺錢,他們希望儘快做到這一點。

- 本季度對Hopper(即H100)的需求持續增長,表明客戶對當前一代產品的強烈興趣。

- 展望未來,NVIDIA預計在推出H200和Blackwell時,市場對這些下一代產品的需求將遠遠超過供應。這表明客戶對NVIDIA的新品有著強烈的興趣和迫切的需求。

- 客戶之所以對新產品如此熱情,是因為先進的AI基礎設施可以幫助他們節省開支,提高收入。儘快部署最新的NVIDIA技術,對他們的業務發展至關重要。

- Jensen沒有明確提到H100會出現需求停頓或放緩的情況。相反,他暗示NVIDIA將同時看到對Hopper、H200和Blackwell的持續強勁需求。

軟體優化可以顯著提高硬體性能,使系統價值加倍成長

黃仁勳:所有這些都運行CUDA,都運行我們的整個軟體堆疊。所以,你今天在我們的軟體堆疊上進行投資,無需做任何事情,它就會變得越來越快。如果你今天投資我們的架構,無需做任何事情,它就會應用到越來越多的雲和資料中心,一切都能正常運行。

我們構建了這個系統,這使得我們能夠優化所有晶片一起工作作為一個系統,並能夠優化跨系統的軟體。簡單來說,如果你有一個 50 億美元的基礎設施,並且你將其性能提高一倍(我們經常這麼做),當你將基礎設施性能提高一倍時,其價值也是 50 億美元。所有在資料中心的晶片都無法支付這個成本。因此,它的價值非常了不起。

我認為我們所帶來的創新步伐將提高性能,降低TCO。因此,我們應該能夠在這個新的計算時代,用NVIDIA架構大規模擴展,並開啟這場新的工業革命,在這場革命中,我們不僅製造軟體,還製造人工智慧權杖,我們將大規模地做到這一點。

- Jensen提到,通過CUDA演算法創新,NVIDIA能夠將H100上的LLM推理性能提高多達3倍,這表明了其架構和軟體的豐富性。這些性能改進不僅降低了服務成本,還提升了模型訓練和推理的效率。

- Jensen強調,無論NVIDIA推出怎樣的新硬體架構,都將與其現有軟體生態系統完全相容。客戶在NVIDIA軟體堆疊上的投資,將隨著硬體升級而持續獲得"免費"的性能提升,無需修改代碼或重新訓練模型。

- NVIDIA在軟體和演算法方面的創新本身就是性能提升的重要引擎。通過優化軟體實現、改進數值庫、發明新演算法等,NVIDIA可以在相同硬體上實現數倍甚至數十倍的性能提升。

- Jensen將軟體視為NVIDIA實現"工業革命"願景的關鍵要素。支撐AI模型大規模生成智慧應用和服務的,正是NVIDIA在AI軟體棧和開發工具上的深厚積累和持續投資。

Jensen在這裡強調了幾個關鍵點:

- NVIDIA構建了一個完整的系統(即AI工廠),使其能夠從整體上優化和協調各個元件,包括晶片和軟體。

- 通過將所有晶片作為一個系統進行優化,NVIDIA能夠將整個系統的性能提高一倍或更多。

- 當一個價值50億美元的基礎設施的性能提高一倍時,其價值的提升(50億美元)遠遠超過了所有晶片的成本。

- 這突顯了系統級優化的巨大價值,而這是單純的硬體升級或單點優化難以企及的。

對NVIDIA運算和網路的前期1美元投資,在4年內可轉化為雲端服務提供商(CSP) 5美元的營收:

左側圓餅圖:4 年的 AI 基礎設施成本

- 總成本:約 10 億美元:建立和運行 AI 基礎設施在 4 年內的總成本,其中GPU運算和網路約佔一半,另一半是資料中心設施建造與運營的成本。

- 16K GPU:這部分顯示了 GPU 計算的成本分佈。

- 網絡:這部分顯示了網絡成本。

- 數據中心設施建設和運營:這部分顯示了數據中心設施的建設和運營成本。

右側圓餅圖:4 年的租賃機會

- 總收入:約 25 億美元:基於每 GPU 小時 4 美元的租賃價格在 4 年內的總收入。

- 性能提升 25% 價值 6 億美元以上:通過提升性能,可以額外產生 6 億美元以上的收入。

- 利用率提升 15% 價值 3.5 億美元以上:通過提高設備利用率,可以額外產生 3.5 億美元以上的收入。

Blackwell整理

- 定位與性能:

- Blackwell是為萬億參數規模的AI而設計的全新平臺,而不僅僅是一個GPU。

- 與上一代產品Hopper相比,Blackwell可以將訓練速度提高4倍,推理速度提高30倍,能效比Hopper高25倍。

- 架構與組成:

- Blackwell平臺包括Grace CPU、Blackwell GPU、NVLink、Quantum InfiniBand、Spectrum乙太網交換機等元件。

- Blackwell GPU採用全新架構,專為大規模生成式AI和萬億參數語言模型而優化。

- Grace CPU與Blackwell GPU高度集成,提供更大的記憶體頻寬和更快的互連。

- 全新的NVLink和交換機可支援多達72個Blackwell GPU的超大規模互聯。

- 各種配置:

- Blackwell可適配各種資料中心環境,支持風冷和液冷、x86和Arm CPU、InfiniBand和乙太網等不同選項。

- 發佈時將有100多種OEM和ODM系統支援Blackwell,數量是Hopper發佈時的兩倍,代表了全球所有主要的電腦製造商。

- 靈活多樣配置有利於Blackwell在不同客戶、工作負載和資料中心環境中快速普及。

- 時間表與供應:

- 首批面向關鍵客戶的Blackwell系統已經交付,包括OpenAI創始人Sam Altman。

- Blackwell目前已經進入全面生產階段,第二季度開始出貨,第三季度出貨量進一步提升。預計客戶將在第四季度開始部署Blackwell系統並投入使用。

- Blackwell的需求已經遠遠超過了供應,這種情況可能會持續到明年。

- 今年會有很多Blackwell的收入。

- 生態系統支援:

- 主要雲廠商如亞馬遜、Google、Meta、微軟等都將採用Blackwell。

- OpenAI、Anthropic等AI初創公司是Blackwell的首批用戶。

- 英偉達與生態系統夥伴合作,加速針對Blackwell平臺的軟體和應用開發。

- 重要意義:

- Blackwell代表了計算架構的根本性變革,標誌著生成式AI時代的到來。

- Blackwell的推出將加速AI工廠的建設和推廣,帶動AI計算產業的爆發式增長。

- Blackwell平臺有望在未來幾年將AI性能提升1000倍,推動人工智慧發展進入新的階段。

公司表示:液冷已經做好準備

Q:我很好奇Blackwell與Hopper的部署情況有何不同。之所以這麼問,是因為大規模的液冷此前從未實現過,在節點層面和資料中心內都存在一些工程挑戰。那麼,這些複雜性是否會延長過渡時間?你如何看待這一切?

A:Blackwell有多種配置。Blackwell是一個平臺,而不是一個GPU。該平臺包括支持風冷、液冷、x86和Grace、InfiniBand,現在還有Spectrum-X,以及我在GTC上展示的超大規模NVLink。

對於一些客戶來說,他們將部署到已經在運行Hopper的現有資料中心。他們將輕鬆地從H100過渡到H200,再到B100。所以Blackwell系統在設計時就考慮了向後相容性,我們也一直在為生態系統做好液冷準備。我們與生態系統討論Blackwell已經有一段時間了。CSP、資料中心、ODM、系統製造商、我們之外的供應鏈、液冷供應鏈基地、資料中心供應鏈基地,沒有人會對Blackwell的到來和我們希望通過Grace Blackwell 200提供的功能感到驚訝。通過Grace CPU和密度更高的計算,液冷將為資料中心節省大量資金,不僅在能源使用方面,而且還體現在製冷設備的投入上。

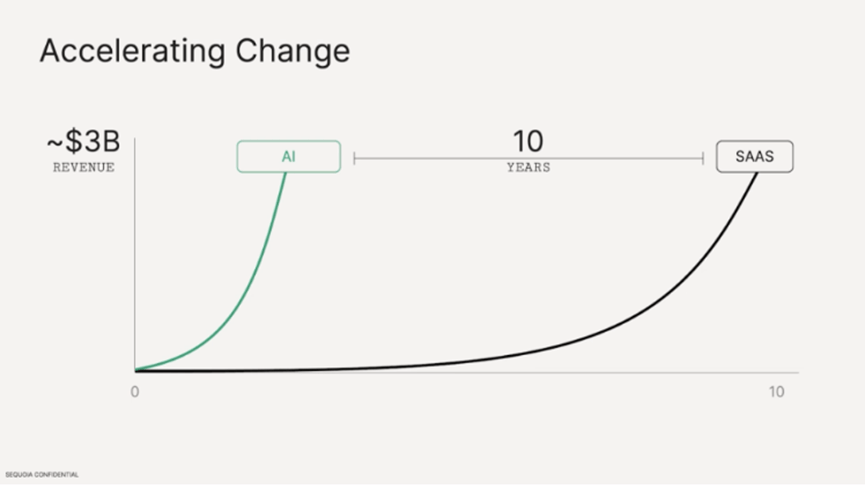

補充:2024/3 紅杉資本最新看法

- 2010 年左右。整個軟體全球 TAM 約為 3500 億美元,其中只有 60 億美元是雲軟體。

- 2023年軟體TAM 從大約 3500 億增長到 6500 億,但雲這一部分已成長為 4000 億美元的收入,這是 15 年裡 40% 的複合年增長率。這是巨大的增長。

- 生成式 AI 現在的收入總計大約為 30 億美元: SaaS 市場花了近十年的時間才達到這個收入水準,而生成式 AI 在第一年就達到了這個水準。

- 相較於已投入的500 億美元加上能源與資料中心成本等等。目前營收只得到 30 億顯然仍有問題需要解決。

- 與一年前預估的差異:將AI分成基礎模型、開發工具和基礎設施、應用等三層,一年前原本預估由於基礎層的新興技術突破,應用層將出現大爆發,但相反的是發現新公司以倒置的方式形成。

- 越來越多基礎模型正在出現,並獲得了非常大的融資輪。

- 應用層則是才剛開始,尚未有明確應用。

- 採訪用戶不堅持使用AI應用的最大原因是期望與現實間的差異,但紅杉資本認為隨著AI越來越智能(Sora和Claude3發布),應用將越來越明確。

- 我們相信 AI 主要是一場生產力革命,這些革命遵循一個模式。它開始於人類使用工具,過渡到人類使用機器助手,最終轉變為人類與機器網路共存。AI 將感覺更像是一個同事而不是一個工具。

- 標普 500 公司中生成 100 萬美元收入所需的工人數量,這個數字正在迅速下降,我們正在進入一個這一趨勢將繼續下降的時代。我們認為 AI 定位於幫助降低成本,提高生產力。

你必須登入才能發表留言。